Best Practice Forschungsprojekte

Semantische Segmentation für Mixed Reality

Motivation

Mixed Reality-Anwendungen erlauben es, Bilder eines virtuellen Systems mit der echten, physikalischen Umgebung des Benutzers zu überblenden. Um eine exakte Überlagerung, z.B. virtuell eingeblendeter Leitungen mit physikalisch vorhandenen Steckdosen zu ermöglichen, sind aktuell lästige Vorbereitungen der Umgebung notwendig, z.B. das Anbringen von Marken.

In der Computer-Vision wurden in dem letzten Jahrzehnt durch Convolutional Neural Networks (CNNs) große Fortschritte in der Bildklassifizierung, der Objekt- Detektion und der semantischen Segmentierung ermöglicht. Ziel des Gesamtprojekts ist es, diese Fortschritte für das Kamera-Tracking von Mixed Reality-Anwendungen zu verwenden. Ein erster Meilenstein ist dabei die Auswertung der Qualität der semantischen Segmentierung in typischen Mixed Reality-Umgebungen.

Realisierung

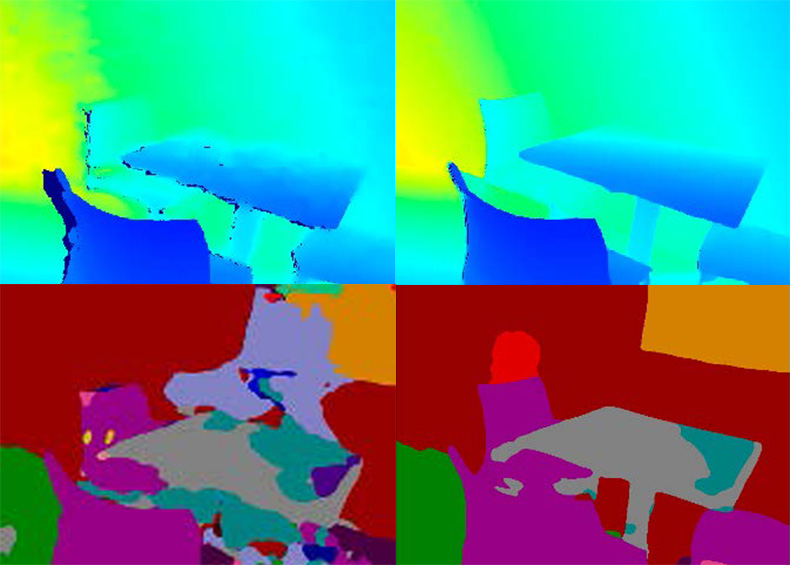

Die Anwendung von semantischer Segmentierung in der Mixed Reality stellt hohe Anforderungen, da Daten in Echtzeit verarbeitet werden müssen. Andererseits sind typische Mixed Reality-Brillen mit mehreren kalibrierten Kameras ausgestattet, die eine Entfernungsberechnung zulassen. Im Stand der Technik zeichnet sich EMSANet als eine Umsetzung der semantischen Segmentierung auf RGB-D Daten durch seine Echtzeitfähigkeit und seine hohe Genauigkeit aus.

In unserer Anwendung soll EMSANet auf Innenraumdaten angewendet werden, da dies eine typische Arbeitsumgebung für Mixed Reality-Anwendungen, z.B. im Renovierungs- oder Remote-Support-Bereich, ist. Für die Anwendung wurde eine RGB-D Kamera mit einem aktiven Stereo-Modul im Infrarotbereich gewählt. Der Algorithmus benötigt zum Training viele Daten, um die semantischen Klassen der Pixel zu erlernen. Da die anwendungsspezifische Aufbereitung der Daten gerade für kleine Unternehmen oft viel zu aufwändig ist, wurde eine öffentliche Trainingsdatenbank verwendet, die möglichst ähnliche Daten aufweist.

Das Paper mit Ergebnissen und weiteren Informationen können Sie hier herunterladen..

Eckdaten

Projektleitung

Prof. Dr.-Ing. Anita Sellent

Kooperationspartner

Sonali Patil, Georgia Albuquerque, Andreas Gerndt,

Deutsches Zentrum für Luft- und Raumfahrt

Laufzeit

1.4. – 30.9.2023

Kontakt

Download

| Semantische Segmentation für Mixed Reality | |

| PDF, 656 KB | |