AI4MediaData

Connecting Media with Usage Data

Connecting Media with Usage Data

Der im BMWK-Forschungsprojekt „AI4Media-Data“ entwickelte Algorithmus „Highlight Search“ bietet einen Ansatz, um emotionale Highlights in Reality-TV-Formaten zu identifizieren. Auf Basis von audiovisuellen Features und Nutzungsdaten wurde ein Algorithmus entwickelt, der besonders emotionale Szenen in ganzen Episoden eines TV-Formats ermittelt und diese zur Nutzung durch Redakteur:innen in Form von Schnittmarken in anpassbaren Längen ausgibt, um daraus kurze Highlight-Clips vereinfacht erstellen zu können.

Das Ziel von „Highlight Search“ ist es, mithilfe von KI-Algorithmen emotionale bzw. dramaturgische Highlights in ganzen Folgen am Beispiel von Reality-TV-Formaten zu identifizieren und Schnittmarken für diese Highlights automatisiern auszugeben, um Mitarbeiter:innen von Medienunternehmen datenbasiert zu unterstützen. Die Ergebnisse des Algorithmus' sind als smartes Assistenzsystem zu verwenden.

Mit der zunehmenden Entwicklung von Online-Angeboten und der steigenden Bewegtbildorientierung sind Videos zu den beliebtesten visuellen Medien für Unterhaltung und Kommunikation geworden (Qi et al., 2020). Medienunternehmen (z. B. TV-Sender), aber auch Privatpersonen (z. B. Creator von User Generated Content) produzieren und laden in immer größerem Umfang Videoinhalte hoch. Das Indizieren, Organisieren und Durchsuchen dieser zahlreichen Videodaten wird immer schwieriger. Die Identifizierung von Video-Highlights, die aus einem Video (z. B. eine ganze Folge eines TV-Formats) die für Rezipient:innen bzw. Zuschauer:innen interessantesten Video-Clips auswählt, ist ein vielversprechender Ansatz, um diesen Herausforderungen zu begegnen. Darüber hinaus kann die Erkennung von Highlights auch die Abfrage von Videos verbessern und Videoempfehlungen erleichtern, indem entscheidende Merkmale (engl. Features) aus den Videos extrahiert werden. Rezipient:innen konsumieren Videoinhalte, um gemäß Uses-and-Gratifications-Theorie bestimmte emotionale Bedürfnisse zu befriedigen (z. B. Langeweile zu vertreiben) (S. Wang & Ji, 2015). Daher ist es notwendig, Videos auf Basis ihres affektiven Inhalts zu analysieren.

Die Erkennung von Highlights, die bei Rezipient:innen solche Emotionen hervorrufen können, ist jedoch äußerst schwierig. In der Regel hängt das Interesse an einem bestimmten Video-Clip stark von subjektiven emotionalen Reaktionen der Rezipient:innen ab. Insbesondere bei Reality-TV-Formaten kann eine große Bandbreite von Emotionen hervorgerufen werden (u.a. Freude, Wut, Trauer, Ekel, Überraschung), was eine automatisierte Erkennung erschwert.

Bisher erfolgt die Auswahl von Highlight-Clips deshalb auf Basis von subjektiven Einschätzungen und Erfahrung von Mitarbeiter:innen in Medienunternehmen (z. B. Cutter:innen, Redakteur:innen, Content Manager:innen).

Dieses Vorgehen ist sehr zeit- und ressourcenintensiv, da die Mitarbeiter:innen in der Regel das gesamte Material manuell sichten müssen. Zudem besteht die Gefahr, dass unpassende Highlights identifiziert werden und dadurch das Zuschauer:innen-Erlebnis nicht vollständig ausgeschöpft werden kann.

Um diese Probleme zu lösen, wurde im Rahmen des BMWK Forschungsprojekts „AI4MediaData“ in einem (Teil-)Konsortium von ZDF Digital, Fraunhofer IAIS und der Hochschule Mainz ein Ansatz zur datengestützten Entscheidungshilfe für die Auswahl von Inhalten entwickelt. Die prototypische Anwendung „Asset Match“ unterstützt, indem bestehende Metadaten durch Verfahren der Künstlichen Intelligenz (KI) mit zusätzlichen Szenen- und Framebasierten Metadaten angereichert und Inhaltsempfehlungen ausgespielt werden, die auf Grundlage inhaltlicher Ähnlichkeit der Videos zur Suchanfrage passen. Die Anwendung „Asset Match“ kann zusätzlich das Vertriebsteam von Medienunternehmen bei der Suche nach inhaltlich passendem Content aus dem eigenen Archiv unterstützen und hilft so, die Weiterverwertung von Content effizienter zu gestalten.

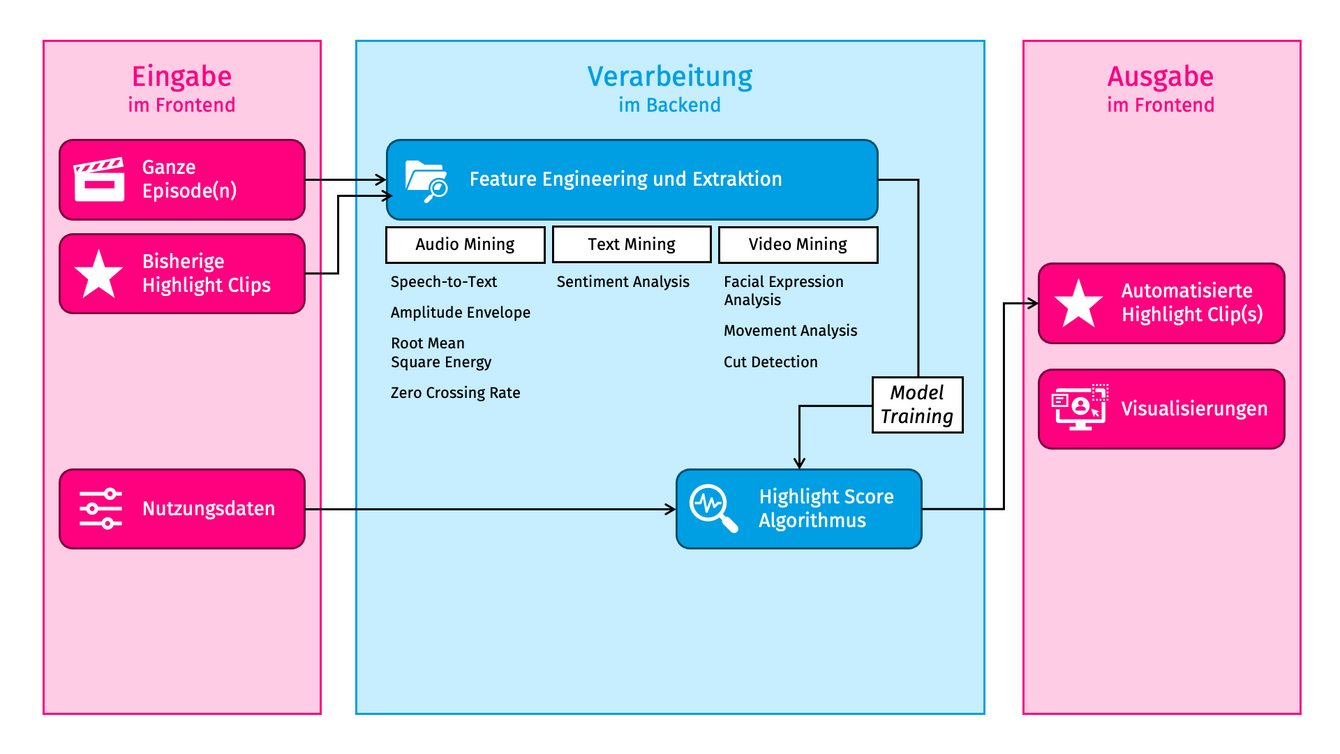

Das Grundprinzip des entwickelten KI-Algorithmus besteht darin, aus den verfügbaren Merkmalen (Features) und deren Bewertungen (Scores) einen allgemeinen „Highlight- Score“ pro Frame zu generieren und wiederkehrende und prägnante Muster in den Daten zu erkennen, die als Indikatoren für ein potenzielles Highlight dienen können (siehe Abbildung 1).

Abbildung 1: Funktionsweise des „Highlight Search“-Algorithmus.

Der „Highlight Search“-Algorithmus zur Identifikation von emotionalen Highlights wurde in Kooperation mit Mitarbeiter:innen von Medienunternehmen – in ihrer Rolle als künftige Nutzer:innen – iterativ aufgebaut und entwickelt.

Das Grundprinzip des entwickelten KI-Algorithmus besteht darin, aus den verfügbaren Merkmalen (Features) und deren Bewertungen (Scores) einen allgemeinen „Highlight-Score“ pro Frame zu generieren und wiederkehrende und prägnante Muster in den Daten zu erkennen, die als Indikatoren für ein potenzielles Highlight dienen können.

Bei Highlight-Clips handelt es sich um einzelne Sequenzen bzw. Szenen, die Zuschauer:innen (z. B. im Anschluss an die Folge) in kurzer Form (erneut) in Plattformen des Senders oder von Dritten sehen möchten, da sie bestimmte emotionale Reaktionen hervorrufen bzw. besonders interessante Aspekte zeigen oder weil sie die gesamte Folge nicht schauen konnten.

Die Erkennung erfolgt in der Regel in zwei Schritten:

Zunächst wird eine Reihe von Features für jeden Frame im Video erzeugt. Diese Features beruhen sowohl auf der Audiospur als auch auf den einzelnen Bildern des Videos. Die visuellen Daten aus den einzelnen Bildern (Frames) können weiter unterteilt werden in pixelbasierte (z. B. Farbe, Helligkeit, Bewegung) und inhaltliche (z. B. Personen, Objekte, Emotionen) Informationen. Das auditive Signal kann wiederum in Sprache, Musik und Umgebungsgeräusche unterteilt werden. Die Auswahl der im Projekt verwendeten Features basieren auf der inhaltlichen Passung der entsprechenden TV-Formate sowie der Anzahl an Nennungen in wissenschaftlichen Publikationen.

Texte teilweise zitiert aus: FKT – Fachzeitschrift für Fernsehen, Film und Elektronische Medien, 12/2022, 30–35.